“L’energia geotermica”

Cosa accomuna un centro termale e un soffione boracifero? L’energia geotermica!

Alla diciassettesima edizione della Settimana della Cultura Scientifica e Tecnologica, l’ingegnere chimico Franco Sansone ne ha illustrato le caratteristiche e il modo in cui questa viene utilizzata dalle centrali per la creazione di energia elettrica.

Che cos’è quindi l’energia geotermica?

Questa è definita come il calore contenuto all’interno del magma che risale in superficie sotto forma di vapore. La terra infatti, al momento della sua formazione, più di 4,5 miliardi di anni fa, racchiuse nella sua parte più interna materiali radioattivi il cui decadimento nucleare ha generato calore con temperature sempre più alte in base alla profondità; possiamo infatti dividere il nostro pianeta in quattro strati: crosta, mantello, nucleo esterno e nucleo interno.

Nella crosta, che si estende fino ai 35 km di profondità, per un gradiente di 30°C/km, presenta una temperatura di circa 1000°C nella sua parte più interna; il mantello si estende invece dai 35 i 2900 km e raggiunge la temperatura di 3400°C. Il centro della terra invece, il punto più caldo, si trova a 6500 km dalla superfice terrestre e la temperatura arriva fino ai 6500°C.

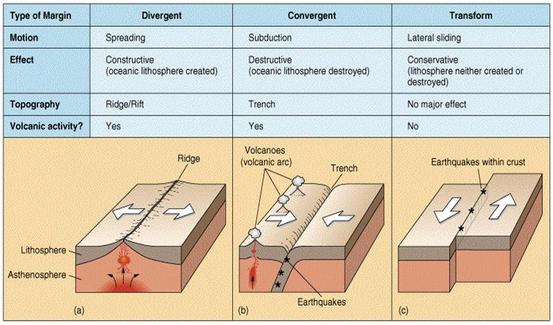

A noi però interessa ciò che accade nella crosta terrestre, dove sono presenti anomalie termiche in diverse zone del pianeta che, oltre ad una maggiore concentrazione del calore, sono caratterizzate da frequenti fenomeni sismici. In queste regioni infatti sono presenti i margini delle placche tettoniche che presentano tre tipi possibili di movimento: divergente, convergente e il lateral sliding.

Sono soprattutto grazie ai primi due tipi che è possibile l’utilizzo dell’energia geotermica: il primo ha un effetto costruttivo in quanto le due placche vicine, muovendosi, creano uno spazio che permette la risalita del magma; i margini convergenti permettono la formazione di fossati, chiamati trench, che creano una condizione di pressione che comporta alla risalita del magna. Il terzo tipo di movimento invece non presenta alcun effetto sensibile e non vi è quindi nessuna risalita di magma.

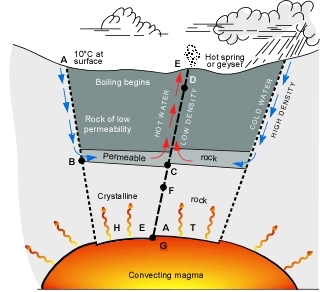

È dopo aver chiarito questi concetti che ci si è soffermati su un ulteriore questione: come si trasmette il calore? Per convezione, un tipo di trasporto che viene utilizzato principalmente dai fluidi: il magma fornisce calore alle zone più superficiali della crosta terrestre, scaldando una parte di acqua la quale si espande, riducendo la propria densità, e che viene quindi spinta dall’acqua fredda che la rimpiazza. L’acqua calda ha una temperatura e una pressione tale che, raggiunta la crosta terrestre, libera vapore nell’atmosfera.

È a questo punto che l’Ing. Sansone ha soffermato la nostra attenzione sull’importanza del magma, la cui presenza è una condizione necessaria ma non sufficiente affinché si possa sfruttare una risorsa geotermica. Sono necessari altri e tre elementi: una sorgente di calore, un fluido e un serbatoio che presenta uno strato di rocce impermeabili sopra e sotto ma che, al contrario, è permeabile ai lati in modo tale che sia possibile all’acqua o al vapore di penetrare nel serbatoio.

Nonostante quindi potesse sembrare un tipo di energia estremamente semplici, ci siamo dovuti ricredere: i sistemi geotermici per la produzione di energia elettrica sono esattamente due: quelli ad acqua dominante e quelli a vapore dominante. È quest’ultima la migliore in quanto permette di utilizzare direttamente il vapore per la creazione di energia.

È in questo momento che l’Ing. Sansone ci ha spiazzati: nonostante infatti l’energia geotermica è usata solo per l’1%, esistono più tipi di centrali per ogni sistema geotermico e inizialmente queste centrali non riuscivano a salvaguardare neanche l’ambiente.

Le centrali per i sistemi ad acqua dominante sono ad esempio le centrali a ciclo binario, dove viene utilizzato un fluido basso bollente, organico (per questo chiamate anche ORC), che bolle a pressioni più basse di quelle dell’acqua: l’acqua calda viene estratta dal terreno, attraversa scambiatori di calore, si raffredda e viene iniettata in serbatoi; raffreddandosi, il fluido geotermico riscalda e fa evaporare il fluido basso bollente, il quale anch’esso va in una turbina, si espande e genera energia meccanica e quindi elettrica. Viene poi condensato a bassa pressione, pompato, recupera pressione per essere reiniettato nel suolo.

Per quelli invece a vapore dominate, come la centrale di Larderello, la più importante in Italia, il vapore viene direttamente estratto e inviato in turbina. In questo caso si possono avere due tipi di impianti: il primo a contropressione, non più utilizzato, in cui il vapore espandeva in turbina e veniva rilasciato direttamente nell’atmosfera; il secondo a condensazione, dove il vapore fuoriesce a pressioni molto più basse, espandendosi molto di più per poi, dopo essere stato condensato, viene reiniettato nel suolo.

Reiniezione è quindi estremamente importante: negli anni Settanta si usavano le turbine a contro pressione, il vapore veniva inviato nell’atmosfera e vi era uno sfruttamento del serbatoio; la pressione e la portata man mano diminuivano.

Negli anni 80 iniziò la partica della reiniezione vi fu una ripresa di pressione e di portata, il serbatoio non venne più sfruttato ma “coltivato, rimanendo disponibile continuamente e non fino al suo esaurimento.

Alla fine della conferenza avevamo imparato moltissime cose, approfondendo un tema che molto spesso non viene considerato ma che potrebbe diventare un’importante metodo di produzione di energia rinnovabile.

E voi, sapevate queste cose?

Raschiatore Antonella 4H

“L’energia geotermica” Leggi tutto »